Docker Grundlagen: Wie Container-Virtualisierung funktioniert

Docker Grundlagen: Wie Container-Virtualisierung funktioniert

Moderne Softwareentwicklung braucht Geschwindigkeit, Konsistenz und effiziente Ressourcennutzung. Der Wechsel von monolithischen Anwendungen zu Microservices und die Einführung von CI/CD-Pipelines haben traditionelle Deployment-Methoden obsolet gemacht. Diese Entwicklung hat die breite Einführung der Containerisierung vorangetrieben, angeführt von Docker.

Dieser Artikel richtet sich an Entwickler, DevOps-Ingenieure und technisch interessierte Leser, die die Grundkonzepte von Docker verstehen und wissen wollen, warum Docker Virtual Machines (VMs) in vielen Anwendungsszenarien abgelöst hat.

Was du aus diesem Artikel mitnimmst:

- Ein klares Verständnis der architektonischen Unterschiede zwischen Docker-Containern und VMs

- Wie Docker Ressourceneffizienz und Deployment-Geschwindigkeit in modernen DevOps-Workflows radikal verbessert

- Die entscheidende Rolle von Linux-Kernel-Features wie Namespaces und cgroups für Container-Isolation

- Wann Container die bessere Wahl sind und wann VMs weiterhin unverzichtbar bleiben

Container vs. Virtual Machines: Der fundamentale Unterschied

Sowohl Docker als auch VMs isolieren Anwendungen und sorgen für Portabilität, aber sie erreichen das auf völlig unterschiedlichen Abstraktionsebenen. Diese Differenz zu verstehen ist entscheidend für eine optimale DevOps-Strategie.

Virtual Machines: Hardware-Level-Isolation

Eine Virtual Machine (VM) virtualisiert den kompletten Hardware-Stack.

- Architektur: VMs brauchen einen Hypervisor (Typ 1 oder Typ 2), der virtuelle Hardware emuliert. Darauf muss ein vollständiges Gastbetriebssystem (Guest OS) installiert und gebootet werden – inklusive eigenem Kernel und User Space.

- Isolation: Die Isolation ist stark, weil jede VM ihren eigenen, dedizierten Kernel besitzt. Das bietet die höchste Trennung für Workloads, die strikte Sicherheitsgrenzen benötigen oder verschiedene Betriebssysteme auf einem Host laufen lassen müssen.

- Ressourcen: VMs sind ressourcenintensiv. Das vollständige Guest OS führt zu erheblichem Overhead bei CPU, RAM und vor allem der Image-Größe, die typischerweise in Gigabytes (GB) gemessen wird.

Docker Container: Betriebssystem-Level-Virtualisierung

Docker nutzt Betriebssystem-Virtualisierung und verwendet dabei Features, die bereits im Linux-Kernel eingebaut sind.

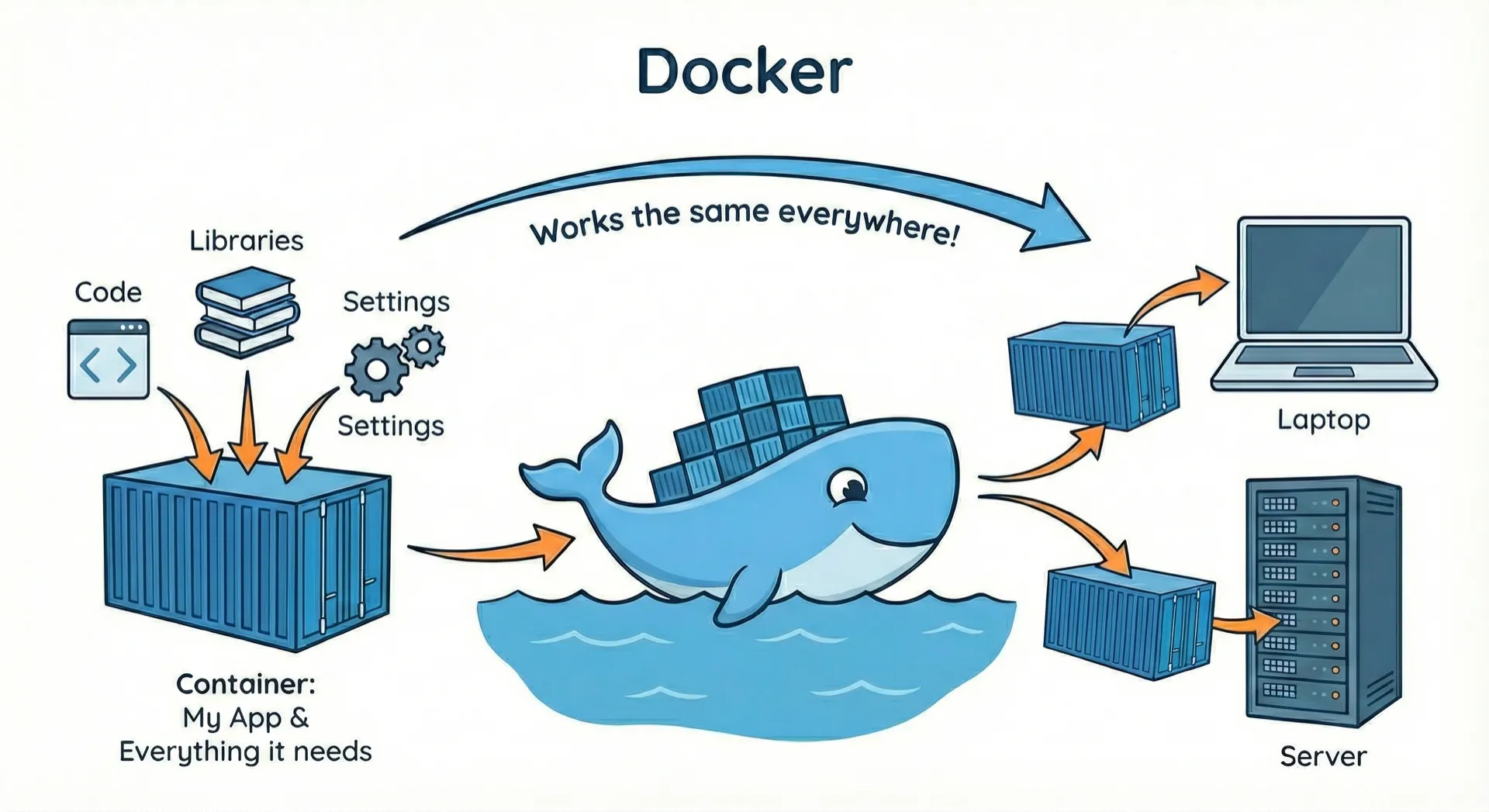

- Architektur: Container teilen sich den Kernel des Host-Betriebssystems. Sie packen nur die Anwendung und ihre benötigten Abhängigkeiten (Bibliotheken, Binaries, Konfigurationsdateien) in einen isolierten User Space. Dieses selbstständige, schlanke Paket ist ein Docker Image.

- Isolation: Die Isolation wird durch Kernel-Features wie Namespaces und Control Groups (cgroups) erreicht (siehe unten). Sie ist robust für Anwendungs-Isolation, aber nicht so stark wie die dedizierte Kernel-Isolation einer VM. Container isolieren Prozesse, nicht ganze Systeme.

- Ressourcen: Container sind extrem leichtgewichtig. Da sie kein Guest OS mit sich tragen, starten sie in Millisekunden und verbrauchen nur die Ressourcen, die für den Anwendungsprozess wirklich nötig sind. Image-Größen reduzieren sich auf Megabytes (MB).

Performance und Effizienz: Der CI/CD-Beschleuniger

In modernen DevOps-as-a-Service-Umgebungen ist Agilität der Schlüssel – die Fähigkeit, schnell zu bauen, zu testen und zu deployen. Hier zeigt Docker seine Stärken.

Der Geschwindigkeitsvorteil: Startzeit und Dichte

Dockers schlanke Architektur führt direkt zu überlegenen Performance-Metriken:

| Feature | Docker Container | Virtual Machine (VM) |

|---|---|---|

| Startzeit | Millisekunden (Prozessstart) | Minuten (vollständiger OS-Boot) |

| Ressourcen-Overhead | Minimal; geteilter Host-Kernel | Hoch; dediziertes Guest OS |

| Image-Größe | MB (Anwendung + Abhängigkeiten) | GB (Anwendung + vollständiges OS) |

| Host-Dichte | Sehr hoch (viele Container pro Host) | Niedriger (weniger VMs pro Host) |

Diese schnelle Startzeit ist kritisch für Continuous Integration (CI), wo das Testen und Bauen hunderter Images schnell passieren muss, um Feedback-Loops zu verkürzen. Die hohe Dichte ermöglicht es Unternehmen, mehr Workloads auf derselben Hardware zu betreiben – das führt zu erheblichen Kosteneinsparungen und besserer Ressourcennutzung.

Portabilität und Konsistenz: Das "Läuft auf meinem Rechner"-Problem lösen

Docker löst das langjährige Problem inkonsistenter Umgebungen. Ein Docker Image ist ein zuverlässiges, ausführbares Paket, das alles enthält, was zum Ausführen der Software nötig ist.

- Von Entwicklung zu Produktion: Der Container auf dem lokalen Entwicklerrechner ist funktional identisch mit dem Container in Staging oder Produktion. Diese Umgebungskonsistenz eliminiert Konfigurationsdrift und Bugs, die durch unterschiedliche OS-Versionen, Bibliotheken oder Abhängigkeiten entstehen.

- Skalierbarkeit: In Kombination mit Container-Orchestrierung (wie Kubernetes) ermöglicht Docker effizientes, automatisiertes Scaling von Microservices. Die Leichtgewichtigkeit von Containern ist die Voraussetzung dafür, schnell Instanzen in einem Cluster zu erstellen und zu verteilen, um schwankende Nachfrage zu bedienen.

Die technischen Grundlagen: Namespaces und Control Groups

Das Geheimnis von Docker liegt in der intelligenten Nutzung mächtiger, bereits vorhandener Features im Linux-Kernel. Diese Mechanismen zu verstehen ist wichtig für technisch versierte Leser.

Namespaces: Der Schlüssel zur Isolation

Namespaces sind die primäre Technologie für Isolation in einer containerisierten Umgebung. Sie umhüllen eine Gruppe von Systemressourcen und präsentieren sie einem Prozess so, als wären sie ausschließlich diesem Prozess gewidmet.

Namespaces teilen den Kernel auf und machen globale Ressourcen (wie Prozess-IDs, Netzwerk-Interfaces und Dateisysteme) container-spezifisch:

- PID Namespace: Container haben ihren eigenen Prozessbaum, beginnend mit PID 1. Prozesse innerhalb des Containers können Prozesse außerhalb ihres Namespaces nicht sehen oder beeinflussen.

- NET Namespace: Jeder Container kann seinen eigenen isolierten Netzwerk-Stack haben (Interfaces, Routing-Tabellen, Firewalls).

- Mount Namespace: Jeder Container hat seine eigene Sicht auf das Dateisystem, sodass Änderungen isoliert sind und das Root-Dateisystem eindeutig ist.

Control Groups (cgroups): Ressourcen-Verwaltung

Control Groups (cgroups) sind der Mechanismus, der die Ressourcennutzung für einen Prozess oder eine Prozessgruppe verwaltet und begrenzt.

- Ressourcen-Management: Cgroups ermöglichen es der Docker-Engine, die Ressourcen (CPU, RAM, Block-I/O) zuzuteilen und zu begrenzen, die ein Container verbrauchen kann.

- System-Stabilität: Das ist entscheidend für System-Stabilität. Es verhindert, dass eine fehlerhafte oder schlecht programmierte Anwendung in einem Container die Ressourcen des Hosts monopolisiert und schützt so die Performance aller anderen Container und des Host-OS selbst.

Wann VMs weiterhin sinnvoll sind

Trotz der klaren Vorteile von Docker für Anwendungs-Deployments behalten VMs ihren Wert in spezifischen Bereichen:

- Starke Sicherheitsgrenze: Für hochsensible, regulierte Workloads (z.B. kritische personenbezogene Daten), die die stärkstmögliche Isolation benötigen, bleibt der dedizierte Kernel einer VM die bessere Wahl.

- OS-Heterogenität: Wenn du eine Anwendung für ein spezifisches OS (z.B. Windows) auf einem Host mit anderem OS (z.B. Linux) laufen lassen musst, ist eine VM nötig, um das gesamte Guest OS auszuführen.

- Infrastruktur-Ebene: VMs sind besser geeignet für das Betreiben kompletter Infrastruktur-Services wie dedizierte Datenbankserver, komplexe Netzwerk-Appliances oder grundlegende Infrastruktur, die Kernel-Level-Zugriff und Stabilität benötigt.

Fazit: Agilität durch Isolation

Docker hat die Deployment-Landschaft fundamental verändert. Durch die Nutzung von OS-Level-Virtualisierung und mächtiger Linux-Kernel-Features können DevOps-Ingenieure Anwendungen in sofortige, leichtgewichtige und reproduzierbare Container packen. Diese grundlegende Technologie stützt die Flexibilität und Skalierbarkeit von Microservices-Architekturen.

Diese Docker-Grundlagen zu beherrschen – vom Konzept der Images und Container bis zur zugrundeliegenden Macht von Namespaces und cgroups – ist nicht nur eine Best Practice, sondern eine Notwendigkeit für moderne Software-Auslieferung.

Wenn dein Team einen effizienten Weg sucht, die Effizienz von Containern innerhalb eines souveränen DevOps-as-a-Service-Frameworks zu nutzen, besonders eines, das europäische Datensouveränität priorisiert, dann ist die Nutzung von Plattform-Lösungen, die auf diesen Container-Prinzipien basieren, der nächste logische Schritt zur Skalierung deiner Entwicklungs- und Operations-Reife.

Moderne Website in 5 Minuten erstellen und deployen

Lerne, wie du eine moderne Website mit Lovable erstellst und sie kostengünstig auf deutschen Servern mit lowcloud deployst.

n8n selbst hosten: Workflow-Automatisierung auf deinem VPS

Lerne, wie du n8n mit Docker selbst hostest. Ein komplettes Schritt-für-Schritt-Tutorial, um Kosten zu sparen, Datensouveränität zu gewährleisten und Workflow-Automatisierung zu meistern.